Im Reader sind 13 Seiten aus aktuellen Veröffentlichungen und Pressemitteilungen zusammengestellt:

ZUM READER - Download

Dazu: Vortrag von Prof Raschke am Fr, 23.3., 18.00 Uhr im ASS mit anschließendem Nachkolloquium

Zusätzlich:

Ein kurzer einführender Bericht, entnommen aus KORONA Jan 2007:

---------------------------------------------------

Was beeinflusst die Temperatur der Erdatmosphäre wirklich?

Unsere Erde ist mindestens 4,5 Milliarden Jahre alt. In ihrer langen Geschichte haben eine komplexe Vielfalt physikalischer, chemischer, geologischer und dann später auch biologischer Prozesse ihren jetzigen Zustand bewirkt. Das heutige Klima – nehmen wir mal das Referenzjahr 1900, um die jetzige Erwärmung später betrachten zu können – ist Ergebnis dieser Vielfalt und wird durch ständigen Austausch von Energie als Strahlung mit dem Weltraum, von Wärme, Impuls und Masse am Erdboden und auch innerhalb der Erdatmosphäre aufrecht erhalten. Dabei spielen natürlich die Ozeane mit ihrer hohen Wärmekapazität eine entscheidende Rolle.

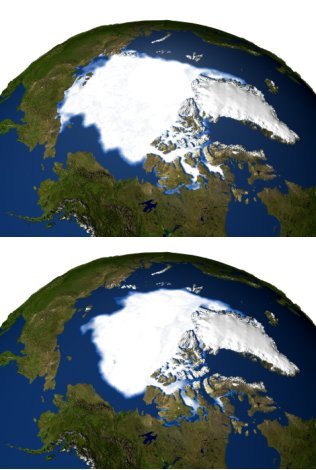

Die einzige Quelle fuer eine Energiezufuhr „von aussen“ ist die Sonne! Alle anderen Energieumsätze innerhalb des Klimasystems erfolgen innerhalb von Kreisläufen; Verluste werden immer wieder durch die Sonne ersetzt. Ihre mittlere Einstrahlung, die „Solarkonstante“, hat derzeit einen Wert von etwa 1365 Wm-2. Vermutlich muss man diesen Wert aufgrund der neuesten Messungen von Satelliten aus auf etwa 1361 Wm-2 korrigieren. Dadurch ändern sich nur Modelldaten – die Erde wird deshalb nicht kühler. Die Wärmezufuhr aus dem Erdinneren ist trotz der vielen Vulkanschlote am Meeresboden und auf den Kontinenten um etwa 5 Zehnerpotenzen geringer. Diese Einstrahlung der Sonne wird zu etwa 30% direkt in den Weltraum zurück reflektiert. Der verbleibende Rest wird durch eine entsprechend hohe Ausstrahlung der Erde von allerdings langwelliger Wärmestrahlung im langjährigen Mittel vollständig kompensiert. Wenn man mal das Analogon eines „Schwarzen Strahlers“ hier nimmt, dann beträgt die mittlere effektive Emissionstemperatur der gesamten Erde, wie man das auch von Satelliten aus stets wieder misst, etwa 254K oder –19°C. An diesem global und über viele Jahre gemittelten Wert sind Emissionen von vielen Oberflächen und schliesslich auch von den Treibhausgasen (s. weiter unten) in der Atmosphäre beteiligt. Insbesondere spielen hier die Wolken eine entscheidende Rolle.

Die (jetzige) vertikale Temperaturverteilung in der Atmosphäre sei hier auch kurz skizziert: Vom Erdboden aus nimmt die Temperatur der Luft im Mittel um etwa 6,5K pro Kilometer Höhenzunahme ab bis zur sogenannten Tropopause, die in Höhen um 6 bis 8 km über den Polargebieten und bis zu 15 bis 17 km über den äquatornahen Tropen liegt und anschaulich als Obergrenze einer ständig vertikal und horizontal durchmischten Luftschicht (genannt Troposphäre) gedeutet werden kann. Darüber erfolgt eine Zunahme der Temperatur bis in etwa 50 km Höhe (Stratopause als Obergrenze der Stratosphäre), über der dann die Lufttemperatur in der Mesosphäre bis zu etwa 85 km Höhe auf ca. 200 K und noch weniger absinken kann. Diese tiefen Temperaturen in dieser Höhe erlauben dem hier nur noch in Spuren vorhandenen Wasserdampf an Staubteilchen zu gefrieren: es entstehen in diesem Höhenbereich die oft sehr schönen Leuchtenden Nachtwolken.

Natürlich gibt es einige regionale Unterschiede.

Wie kommt diese Temperaturschichtung zustande? Zunächst: die Atmosphäre besteht „heute“ zu bereits etwa 98% aus den Gasen Stickstoff und Sauerstoff. Die „Spurengase“ Wasserdampf, Kohlendioxid, Methan, verschiedenen Stickoxiden, und Ozon in Bodennähe sowie insbesondere in der Stratosphäre bilden den Rest. Sie werden zunehmend ergänzt durch verschiedene andere Gase, die oft nur durch menschliche Aktivitäten entstanden sind, wie etwa alle Chlorkohlenwasserstoffe (FCKWs). In dieser Gasatmosphäre schweben, vorzugsweise in der Troposphäre, die Aerosole und natürlich die Wolken. Letztere können nur dank des Wasserdampfes entstehen.

Dominiert wird die oben skizzierte vertikale Temperaturverteilung durch die Einstrahlung der Sonne, die den Erdboden auf (im globalen Jahresmittel) etwa +15°C aufgeheizt. Dieser gibt Wärme an die Atmosphäre ab durch Wärmestrahlung und zusätzlich durch Kaskaden turbulenter Austauschprozesse, zu denen auch die Verdunstung am Boden beiträgt. Die oben in der Reihenfolge ihrer Strahlungswirkung genannten 5 Gase sind fast vollständig durchlässig für die solare Einstrahlung im Spektralbereich zwischen etwa 0,3 und 1,2 µm. Das Ozon absorbiert aber dankenswerterweise das solare Ultraviolett (Wellenlängen < 0,3µm) fast vollständig, so dass nicht nur alles Leben am Boden weitgehend geschützt ist, sondern die Stratosphäre sich auch aufwärmen kann. Der Wasserdampf tritt vorzugsweise in der Troposphäre auf, denn nahe der kalten Tropopause mit Temperaturen um –55 bis -75°C wird er fast vollständig ausgefroren beim Versuch weiter nach oben zu wandern. Die Gase CO2, CH4 und die Stickoxide – sowie auch viele der Chlorkohlenwasserstoffe (FCKWs) sind dagegen mit fast konstantem Mischungsverhältnis bis in Höhen um 70 km vertreten. Diese Gase absorbieren sehr stark die von unten kommende Wärmestrahlung und emittieren gleichzeitig mit der jeweiligen Umgebungstemperatur Wärmestrahlung in alle Richtungen. Dadurch kühlen sich die Trosphäre und auch die Mesosphäre nach oben hin ab. Wolken und Aerosole in der Trosphäre modifizieren das ganze sehr entscheidend. Die Zunahme der Temperatur in der Stratosphäre ist dagegen dem dort vorhandenen Ozon zu verdanken.

So kann man sich sehr vereinfacht die Aufrechterhaltung des Treibhauseffektes unserer Erdatmosphäre erklären. Die Venusatmosphäre wirkt analog; und auch auf dem Mars lässt sich ein schwaches Treibhaus nachweisen. Nun doch etwas zu dem von Herrn Stehlik in den Mittelpunkt gestellten „Modell“: Würde man hypothetisch alle Treibhausgase und damit auch alle Wolken entfernen, dann würde sich bei gleicher Erdalbedo von 30% tatsächlich eine Temperatur am Boden von etwa –18 bis –19°C einstellen. Dieses sehr vereinfachende Argument wurde in der Vergangenheit stets gebraucht um die Bedeutung der Treibhausgase für unser Klima hervorzuheben.

Und nun ändert der Mensch – ein sehr dominanter und agressiver Bestandteil der Biosphäre – die Zusammensetzung der Atmosphäre, wobei er die Konzentrationen von CO2, CH4, Stickoxiden und am Boden auch vom Ozon erhöht und gleichzeitig die des Ozons in der Stratosphäre reduziert. Er hat auch inzwischen fast alle Landoberflächen umgewandelt. Die vielen FCKWs sind seine Erfindung und auch viele der Aerosole. Seit Beginn des Industriezeitalters etwa in der Mitte des 19. Jahrhunderts haben die Konzentrationen der erstgenannten Gase um etwa 35% (CO2), 140% (CH4) und 70% (N2O) zugenommen. Es hat sich dadurch die Absorptions- und gleichzeitig auch Emissionsfähigkeit der Atmosphäre erhöht mit dem Endergebnis, dass sowohl mehr Wärmestrahlung nach unten als noch oben emittiert wird, was inzwischen auch durch Messungen nachgewiesen worden ist. Dadurch kann die Temperatur in Bodennähe zunehmen und in der Stratosphäre und darüber auch abnehmen. Messungen belegen dies bereits! Wir sollten natürlich wieder im Auge behalten, dass das Endresultat nicht ohne die vielen turbulenten (das stört den Amateurastronomen bei seinen nächtlichen Beobachtungen) Austauschprozesse in der Atmosphäre und die Wirkungen von Wolken und Aerosolen und natürlich auch durch Austausch am Erdboden zustande kommen kann.

Wir müssen hier außerdem noch einfügen, dass die Strahlungstransporteigenschaften der genannten Gase und auch der Aerosole und der Wolken durch Messungen und auch durch Rechnungen sehr genau bekannt sind. Diese Werte werden in allen Klimamodellen entsprechend genau berücksichtigt.

Die sehr umfangreichen und gründlich recherchierten Analysen von vielen Eis- und Sedimentbohrkernen – und auch von Stalagmiten vieler Höhlen – erlauben recht gute Rekostruktionen der Klimaverläufe in den vergangenen 500 Jahrtausenden und eine entsprechende Einstufung von deren Ursachen. Hier spielen sowohl Änderungen der Einstrahlung von der Sonne als auch der Treibhausgase (CO2 und CH4 vorzugsweise) eine führende Rolle. Zusätzlich existieren verschiedene Periodizitäten von Strömungssystemen, die zu kurzzeitigen und meist regionalen Anomalien im Klima führen koennen.

Wie versucht man nun die jetzige weltweit zu beobachtende Zunahme der Temperatur in Erdbodennähe und gleichzeitige Abnahme in der unteren Stratosphäre, sowie weitere Änderungen im Klima ursächlich zu erklären? Dazu kann man nur sehr komplexe Modelle verwenden, in denen möglichst gleichzeitig das Klimageschehen in der Atmosphäre, am festen Erdboden mit einem gewissen Austausch in die obersten Bodenschichten und mit der Vegetation und natürlich mit der Atmosphäre und in den Ozeanen mit allen deren Strömungen von unterschiedlich warmen Luft- bzw. Wasserkörpern numerisch nachvollzogen werden. Fuer diese Zwecke werden den Forschern die besten Großrechner zur Verfügung gestellt. Zur Klärung von Unsicherheiten in Prozessabläufen werden sehr kostspielige Expeditionen durchgeführt. Es werden ständig die Routinemessnetze am Boden, in den Ozeanen und auch in Satellitenhöhen ausgebaut. Und die oben erwähnten Untersuchungen des historischen Ablaufes des Klimas bilden eine wesentliche Grundlage um solche Modelle „zu eichen“.

Und noch kennen und wissen wir nicht alles!

Mit solchen sehr komplexen Modellrechnungen konnte aber bereits geklärt werden, dass bis etwa zu den Jahren um 1970 die Temperaturzunahme in Erdbodennähe zu etwa 60% des notwendigen Antriebes mit einer allerdings nicht sehr starken Zunahme der Emission solarer Strahlung erklärt werden. Der Rest geht zu Lasten der seit etwa 1850 gemessenen Anstiege der Treibhausgaskonzentrationen. Der nachfolgende weitere Anstieg erfolgt den Modellrechnungen zufolge allein zu Lasten der Zunahme der Treibhausgase, denn die Sonne hat sich sogar ab etwa 1975 leicht abgeschwächt, wie Satellitenmessungen zeigen. CO2 hat zusätzlich in weiten Teilen der Ozeane die Azitizität des Wassers erhöht, worunter empfindliche Organismen bereits leiden. Dabei soll man aber nicht ausschliessen, dass auch eine uns zunaechst noch unbekannte Fluktuation des Klimas zur derzeitigen Erwärmung beitragen kann.

Wir gestatten uns aufgrund der vorliegenden Ergebnisse eine sehr vorsichtige Prognose zur weiteren Entwicklung des Klimas: Die zunehmenden Konzentrationen der genannten Treibhausgase werden das Klima in Richtung einer Temperaturzunahme in den unteren Schichten der Atmosphäre und am Boden und Abnahme in Tropopausenniveau drängen, was nicht bedeutet, das es dazu kommen muss. Einem solchen „Antrieb (engl.: forcing)“ sind auch in Zukunft natürliche Schwankungen überlagert, die durchaus auch zu kürzeren Abkühlungsperioden in Bodennähe führen können. Die Natur wird sich anpassen; wir Menschen werden auch lernen müssen damit umzugehen. Allein daher und noch verstärkt durch andere und sogar wesentlich drängendere Probleme (z.B. nahendes Ende der fossilen Energievorräte, Überbevölkerung in einigen Regionen) müssen entsprechende „Gegenmaßnahmen“ weltweit getroffen werden.

Die Klimaforschung unserer heutigen Zeit erfolgt durch eine weltweite Zusammenarbeit von vielen Wissenschaftsdisziplinen mit bestens ausgebildetem Personal und sollte daher schon aus diesem Grunde nicht mit oft nur Unwissen signalierender Polemik und Besserwisserei gekontert werden.

Ehrhard Raschke1 und Stefan Bakan2

(1Universitaet Hamburg, 2Max-Planck-Institut fuer Meteorologie Hamburg)

In 60 Jahren von handgroßen Transitoren zu 45 nm Strukturen in der Mikroelektronik

Aus Pro-Physik.de:

Durchbruch bei neuer Chip-Technologie

Durchbruch bei neuer Chip-Technologie

New York/Santa Clara (dpa) - Intel und IBM haben unabhängig voneinander den größten Durchbruch in der Transistoren-Entwicklung seit den sechziger Jahren gemacht. Intel will bereits in der zweiten Jahreshälfte 2007 mit den neuen 45-Nanometer-Chips herauskommen, die unter dem Codenamen «Penryn» entwickelt worden sind, teilte der Chip-Branchenführer mit.

IBM kündigte seinerseits am Samstag Produkte mit dieser Technologie für 2008 an. IBM hat seine neue Technologie in Zusammenarbeit mit dem Intel-Hauptkonkurrenten Advanced Micro Devices sowie den japanischen Elektronikkonzernen Sony und Toshiba entwickelt, betonte die Gesellschaft.

Mark Bohr vom weltgrößten Halbleiterhersteller Intel sagte am Samstag in Santa Clara: «Wir sehen die größte Veränderung in der Transistor-Technik seit den 60er Jahren.»

Dabei will Intel die Herstellung seiner leistungsstärksten Prozessoren auf 45 Nanometer von bisher 65 Nanometer Strukturbreite umstellen. Den neuen Prozessorkern «Penryn» hatte der Chipgigant bereits im Januar 2006 angekündigt. Bei diesen winzigen Strukturen bestand bislang die Gefahr, dass so genannte Leckströme mit einen unkontrollierten Stromfluss im Chipkern auftreten. Mit Hilfe des silberfarbigen Metalls Hafnium wollen die Intel-Ingenieure dies nun verhindern. Zwei weitere Stoffe, die in dem neuen Intel-Rezept die bislang benutzten Chip-Zutaten Siliziumdioxid und polykristallines Silizium ablösen, hält Intel aus Wettbewerbsgründen geheim.

Mit der neuen Technologie kann Intel die Größe der Chips fast halbieren oder die Anzahl der Transistoren in den Chips deutlich erhöhen. Die neuen Mikroprozessoren sollen vermutlich Ende 2007 auf den Markt kommen.

Die Intel-Chips sollen mehr als eine Milliarde Transistoren je Chip haben. Mehr als 30 000 der 45-Nm-Transistoren passen auf einen Stecknadelkopf. Anders ausgedrückt: Mehr als 2000 von ihnen entsprechen dem Durchmesser eines Menschenhaares. Der erste Transistor, der von dem legendären amerikanischen Forschungslabor Bell Labs 1947 entwickelt worden war, hatte hingegen Handgröße.

Unklar blieb am Wochenende, ob sich Intel mit der neuen Technologie signifikant von seinen Wettbewerbern absetzen kann. Auch Texas Instruments arbeitet nach Angaben eines Firmensprechers an einem neuen Produktionsverfahren mit 45 Nanometern, bei dem Hafnium eingesetzt werde.

Weitere Infos:

Intel:

http://www.intel.com

IBM:

http://www.ibm.com

Übertragung von abhörsicheren Quantensignalen über 144 km gelungen

aus ProPhysik.de:

Quantenschlüssel aus der Ferne

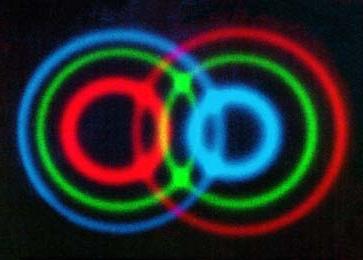

Ein Quantenschlüssel wurde erstmals 144 Kilometer weit mit Licht übertragen. Zusätzliche „Köderphotonen“ garantieren dabei die Abhörsicherheit.

Dank der Quantenkryptographie kann ein Sender (Alice) einem Empfänger (Bob) beliebig lange Bitfolgen zum Verschlüsseln von Nachrichten übermitteln, ohne dass ein Dritter (Eve) sie dabei belauschen könnte. Dazu schickt Alice einzelne, unterschiedlich polarisierte Photonen zu Bob. In der Praxis muss man jedoch Lichtpulse benutzen, die mehrere Photonen enthalten können, sodass Eve unbemerkt Photonen abzapfen und dadurch Information über den Schlüssel erhalten könnte. Dieses Schlupfloch haben jetzt drei Forschergruppen geschlossen und dabei Übertragungsdistanzen von über 100 Kilometern erreicht.

Richard Hughes und seine Kollegen aus Los Alamos und Boulder haben ebenso wie die Forscher um Jian-Wei Pan von der Hefei Universität Photonen durch gut 100 Kilometer lange Glasfaserkabel geschickt, um einen Quantenschlüssel zu erzeugen. Harald Weinfurter von der Universität München und seine Kollegen haben die Photonen von La Palma nach Teneriffa über 144 Kilometer durch die Erdatmosphäre fliegen lassen. Alle drei Gruppen setzten ein gängiges quantenkryptographisches Verfahren ein, das 1984 von Charles Bennet und Gilles Brassard vorgeschlagen worden war, das sie mithilfe von „Köderphotonen“ praktisch unangreifbar gemacht haben.

Nach Bennet und Brassard sendet Alice einzelne, unterschiedlich polarisierte Photonen an Bob. Die Polarisation wechselt dabei in zufälliger Folge zwischen den Zustandspaaren „horizontal/vertikal“ und „+45°/–45° gegen die Vertikale geneigt“ ab. Bob untersucht die ihm unbekannten Polarisationen der eintreffenden Photonen mit einem Analysator, dessen Einstellung ebenfalls in zufälliger Folge zwischen horizontal/vertikal und +45°/–45° wechselt. Nach einiger Zeit teilen sich Alice und Bob offen mit, welche Polarisator- bzw. Analysatoreinstellung sie für das jeweilige Photon gewählt hatten. Stimmen sie überein, so weiß Bob aufgrund seiner Messung, welche Polarisation das von Alice abgeschickte Photon tatsächlich hatte und Alice weiß, dass Bob das weiß. Damit haben beide ein Bit des Quantenschlüssels gewonnen, das nur sie kennen.

Versucht Eve ihnen dieses Bit abzulauschen, so muss sie das entsprechende Photon abfangen und an ihm eine Polarisationsmessung durchführen. Da Eve die Polarisation des Photons nicht kennt, kann sie auch keine „Sicherungskopie“ davon herstellen. Das Photon geht also bei der Messung unwiederbringlich verloren. Sendet Eve dafür ein polarisiertes Ersatzphoton zu Bob, so hat dies häufig die falsche Polarisation, wie Alice und Bob bemerken, wenn sie sich zur Kontrolle nicht nur die benutzten Polarisator- und Analysatoreinstellungen sondern auch die tatsächlich vorliegenden bzw. gemessenen Polarisationen mitteilen.

Die Unangreifbarkeit dieses Verfahrens hat indes praktische Grenzen. Tatsächlich gibt es bisher noch keine Lichtquelle, die nur einzelne Photonen erzeugt. Stattdessen benutzt man stark abgeschwächte Laserpulse, die gelegentlich auch zwei oder mehr Photonen enthalten können. Mit zunehmender Entfernung von Bob muss Alice immer stärkere Lichtpulse mit immer mehr Photonen absenden, damit bei Bob überhaupt noch etwas ankommt. Die überzähligen Photonen in den Lichtpulsen könnte Eve für einen so genannten Photon Number Splitting Attack nutzen. Sie zweigt aus jedem Puls ein oder mehrere Photonen ab, die übrigen gibt sie an Bob weiter, sodass sich die Photonenstatistik der Pulse nicht ändert. Eve hat dann zu jedem polarisierten Lichtpuls, den Bob erhält, Photonen derselben Polarisation. Wenn Alice und Bob sich ihre Polarisator- und Analysatoreinstellungen offen mitteilen, kann Eve Bobs Messung an ihren Photonen wiederholen und seine Information gewinnen.

Doch chinesische Forscher hatten herausgefunden, dass Alice diesen Angriff vereiteln kann, indem sie den Lichtpulsen gelegentlich zusätzliche „Köderphotonen“ hinzugefügt. Die Pulse sollten demnach in zufälliger Folge höhere oder niedrigere Intensität haben. Berechnungen hatten gezeigt, dass Eve den Pulsen keine Photonen entnehmen kann, ohne dass sich dabei die Photonenstatistik der beiden Pulsarten verändert. So können Alice und Bob mit beliebig großer Wahrscheinlichkeit einem Lauschangriff auf die Schliche kommen, ohne auf eine hohe Übertragungsrate verzichten zu müssen. Die Arbeiten der drei Forschergruppen haben das jetzt bestätigt.

So haben Weinfurter und seine Kollegen mit Lichtpulsen einen Quantenschlüssel mit immerhin 42 Bit/s vom Observatorium Roque de los Muchachos auf La Palma zu einem 144 km entfernten Teleskop der ESA auf Teneriffa absolut sicher übertragen. Damit wird auch eine sichere Übertragung von einem Ort der Erde zu einem niedrig darüber hinweg fliegenden Satelliten möglich, der den Schlüssel an einem anderen, von ihm überflogenen Ort sicher wieder abgeben kann. Die Möglichkeiten der Quantenkryptographie sind offenbar grenzenlos.

Rainer Scharf

Weitere Infos:

Originalveröffentlichungen:

Danna Rosenberg et al.: Long-Distance Decoy-State Quantum Key Distribution in Optical Fiber. Phys. Rev. Lett. 98, 010503 (2007).

http://dx.doi.org/10.1103/PhysRevLett.98.010503

http://arxiv.org/abs/quant-ph/0607186

Tobias Schmitt-Manderbach et al.: Experimental Demonstration of Free-Space Decoy-State Quantum Key Distribution over 144 km. Phys. Rev. Lett. 98, 010504 (2007).

http://dx.doi.org/10.1103/PhysRevLett.98.010504

Cheng-Zhi Peng et al.: Experimental Long-Distance Decoy-State Quantum Key Distribution Based on Polarization Encoding. Rev. Lett. 98, 010505 (2007).

http://dx.doi.org/10.1103/PhysRevLett.98.010505

http://arxiv.org/abs/quant-ph/0607129

Gruppe von Richard J. Hughes in Los Alamos:

http://quantum.lanl.gov/hughes.shtml

Gruppe von Harald Weinfurter an der LMU:

http://xqp.physik.uni-muenchen.de

Gruppe von Jian-Wei Pan am Hefei National Laboratory:

http://quantum.ustc.edu.cn/index.asp

Weitere Literatur:

Xiang-Bin Wang: Beating the Photon-Number-Splitting Attack in Practical Quantum Cryptography. Rev. Lett. 94, 230503 (2005).

http://dx.doi.org/10.1103/PhysRevLett.94.230503

http://arxiv.org/abs/quant-ph/0410075

Hoi-Kwong Lo, Xiongfeng Ma und Kai Chen: Decoy State Quantum Key Distribution. Rev. Lett. 94, 230504 (2005).

http://dx.doi.org/10.1103/PhysRevLett.94.230504

http://arxiv.org/abs/quant-ph/0411004

Miloslav Dusek, Norbert Lütkenhaus, Martin Hendrych: Quantum Cryptography. To appear in Progress in Optics, vol. 49.

http://arxiv.org/abs/quant-ph/0601207

Norbert Lütkenhaus und Mika Jahma: Quantum key distribution with realistic states: photon-number statistics in the photon-number splitting attack. New J. Phys. 4, 44 (2002).

http://dx.doi.org/10.1088/1367-2630/4/1/344 (frei!)

Nicolas Gisin et al.: Quantum Cryptography. Rev. Mod. Phys. 74, 145 (2002).

http://dx.doi.org/10.1103/RevModPhys.74.145

http://arxiv.org/abs/quant-ph/0101098

Das kleinste Rad der Welt aus Pro-Physik.de:

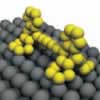

Rollendes NanoradForscher aus Berlin und Toulouse haben erstmals gezeigt, wie sich ein einzelnes molekulares Rad auf einer Kupferoberfläche rollen lässt.

In den letzten Jahren konnte gezeigt werden, wie sich durch Manipulation mit einem Rastertunnelmikroskop einzelne Atome und Moleküle auf der Oberfläche bewegen lassen und sich dabei in Sprüngen („hopping“) fortbewegen. Es konnte bisher jedoch kein „Rollen“ eines molekularen Rades beobachtet werden, obwohl dies eine fundamentale Bewegungsart in der makroskopischen Welt darstellt. Eine Forschergruppe an der Freien Universität Berlin um den österreichischen Experimentalphysiker Leonhard Grill hat nun in Zusammenarbeit mit Wissenschaftern am CNRS (Centre national de la recherche scientifique) in Toulouse/ Frankreich erstmals gezeigt, wie sich ein einzelnes molekulares Rad auf einer Kupferoberfläche rollen lässt. Die Wissenschaftler haben ihre Forschungsergebnisse im international renommierten Fachmagazin „Nature Nanotechnology“ veröffentlicht.

Bei der Entdeckung handelt es sich um das wahrscheinlich kleinstmögliche Nanorad mit einem Durchmesser von nur 0,8 Nanometer - also in der Größenordnung von atomaren Abständen in Kristallen. Zum Vergleich: Der Durchmesser des Nanorads ist etwa 100.000 Mal kleiner als der Durchmesser eines menschlichen Haares.

Genau zu wissen, wie sich eine molekulare Nanomaschine bewegt, ist notwendig, um ihr Design und ihre Funktionsweise weiterentwickeln zu können. Durch die neuesten Erkenntnisse ist es möglich, die molekularen Bewegungen präzise zu kontrollieren und neuartige komplexe Nanomaschinen zu entwerfen.

Um die Rollbewegung zu induzieren, wird von den Forschern die dünne Spitze eines Rastertunnelmikroskops, deren äußerstes Ende im Idealfall von einem einzigen Atom gebildet wird, in einem Abstand von wenigen Atomdurchmessern über ein einzelnes Molekül bewegt. Die Temperatur beträgt nur ungefähr 25 Kelvin, um die thermische Bewegung der Moleküle zu verhindern. Eine elektrische Spannung zwischen der Spitze und der Probe bewirkt einen quantenmechanischen Tunnelstrom, der den Wissenschaftern das direkte Auslesen der molekularen Bewegung (in Echtzeit) ermöglicht. Das Stromsignal zeigt dabei für die durchgeführten Experimente einen typischen „Fingerabdruck“ der Rollbewegung.

Neben dem Rollen konnte auch das Springen des Moleküls von einem Adsorptionsplatz zum nächsten auf kontrollierte Weise herbeigeführt und mit Hilfe des Stromsignals eindeutig charakterisiert werden. Durch einen Vergleich der Manipulation auf verschiedenen Oberflächen und in unterschiedlichen Richtungen konnten die Forscher nachweisen, dass die Fortbewegungsart des Nanorades von der Oberflächenstruktur abhängt: Für eine Rollbewegung ist demnach eine leicht gewellte („korrugierte“) Oberfläche notwendig, während vollkommen flach angeordnete Oberflächenatome kein Rollen des Nanorades ermöglichen.

Ein Vergleich der auf der Oberfläche zurückgelegten Wege der Moleküle beim Rollen oder Springen zeigt einen fundamentalen Unterschied: Während die Moleküle beim Rollen mit Hilfe der Spitze in ihrer Wegstrecke stark eingeschränkt sind, ist dies beim Springen nicht der Fall. Diese Beobachtung entspricht der Art der Fortbewegung: Da beim Rollen die Spitze des Mikroskops über das Molekül hinweg bewegt wird und sich nach einer einzigen Drehung des Rades bereits hinter dem Molekül befindet, ist dies beim Springen bzw. „Schieben“ mit der Spitze nicht der Fall.

Quelle: FU Berlin

Weitere Infos:

Originalveröffentlichung:

Leonhard Grill et al., Rolling a single molecular wheel at the atomic scale, , Nature Nanotechnology, Online Veröffentlichung am 21.1.2007.

http://dx.doi.org/10.1038/nnano.2006.210

Institut für Experimentalphysik der Freien Universität Berlin:

http://www.physik.fu-berlin.de

Homepage von Leonhard Grill - Nanoscience with Functionalized Molecules:

http://www.physik.fu-berlin.de/~grill/

Das Gerüst des Universums

Ein internationales Forscherteam erstellt für einen Ausschnitt des Universums die bisher genaueste Karte über die Verteilung der dunklen Materie.

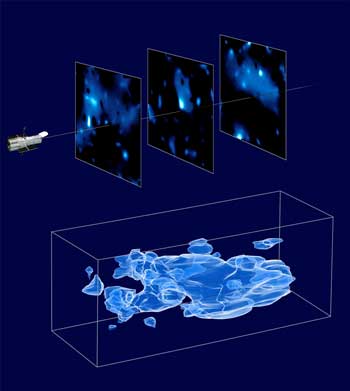

Dunkle Materie gibt dem Universum seine Struktur. Ein internationales Wissenschaftlerteam hat nun eine dreidimensionale Karte dieses unsichtbaren Gerüsts erstellt, um das sich die gewöhnliche sichtbare Materie anordnet. Die Karte zeigt in einem Ausschnitt des Universums sowohl die Verteilung dunkler als auch gewöhnlicher, baryonischer Materie. Dieser Ausschnitt umfasst 500 000 Galaxien und ist der bislang größte, den Astrophysiker auf diese Weise kartografiert haben. An der Karte der normalen Materie hat auch das Max-Planck-Institut für extraterrestrische Physik in Garching mitgearbeitet.

Abb.: Verteilung der dunklen Materie in Blickrichtung des Hubble-Teleskops (COSMOS-Feld). Um die Daten zu gewinnen, teilten die Forscher das COSMOS-Feld in verschiedene Altersschichten ein (vergleichbar den Schnitten durch Gesteinsschichten in der Geologie). Das Alter der Schichten lässt sich aus der Rotverschiebung der beobachteten Galaxien ableiten. Die drei oben gezeigten Schichten stellen also das Universum zu verschiedenen Zeiten in der Vergangenheit dar. Aus der Wechselwirkung der dunklen Materie mit Licht konnte das Wissenschaftlerteam die Verteilung der dunklen Materie berechnen. (Bild: NASA, ESA und R. Massey, California Institute of Technology)

Über 80 Prozent der gesamten Masse des Universums bestehen aus dunkler Materie. Sie sendet keine elektromagnetische Strahlung wie etwa sichtbares Licht aus. Nur durch Gravitation kann sie mit normaler baryonischer Materie oder mit Licht wechselwirken. Und genau diese Eigenschaft nutzte das Wissenschaftlerteam aus, um die dreidimensionale Verteilungskarte der dunklen Materie zu zeichnen. Diese Karte bestätigt die Standardtheorie zur Rolle der dunklen Materie. Astrophysiker betrachten sie nämlich als Gerüst des Universums. Ursprünglich war sie gleichmäßig verteilt, später verdichtete sie sich in manchen Bereichen. Diese Stellen mit besonders viel dunkler Materie ziehen durch ihre stärkere Gravitation die sichtbare Materie an, so dass sich diese zusammenballt. So entstehen Sterne, Galaxien und ganze Galaxienhaufen.

Die jetzt erstellte Karte zeigt ein über das Universum verteiltes Netz dunkler Materie. An manchen Orten ist die dunkle Materie jedoch sehr dicht - und genau an diesen Stellen befinden sich die Galaxien und das heiße Gas der normalen Materie. Diese Verteilung der Materie im Universum zeigt, dass die baryonische Materie der dunklen Materie folgt.

Die Daten, die die Forscher für die Landkarte verwendeten, stammen vom Weltraumteleskop Hubble. Im Rahmen des Cosmic Evolution Survey (COSMOS) hat Hubble einen verhältnismäßig großen Ausschnitt des Weltalls hochaufgelöst abgebildet, nämlich 1,6 Grad im Quadrat. Dieser Ausschnitt, das COSMOS-Feld, hat eine Größe von achtmal der Fläche des Vollmonds und ist damit der bisher größte auf diese Weise vermessene Ausschnitt des Alls. Dabei ist eine umfangreiche Sammlung sehr detaillierter Bilder von einer halben Million Galaxien entstanden. Und weil die Gravitation der dunklen Materie das Licht dieser Galaxien ablenkt, konnten die Forscher im Umkehrschluss aus der Gestalt der Galaxien auf die Verteilung der dunklen Materie schließen.

Die Methode, die sie dabei verwendeten, beruht auf dem schwachen Gravitationslinseneffekt. Der Effekt lässt sich durch eine einfache Analogie erklären: Wenn Licht durch eine Milchglasscheibe mit aufgerauter Oberfläche, wie zum Beispiel bei Badezimmerfenstern, fällt, wirft es ein charakteristisches Muster an die Wand. Dieses Muster gibt Aufschluss darüber, wie die Oberfläche des Glases strukturiert ist. Auf ganz ähnliche Weise haben die Astrophysiker aus der Gestalt der Galaxien die Verteilung der dunklen Materie bestimmt.

Doch nicht nur dunkle Materie, sondern auch baryonische Materie, wie zum Beispiel ein Stern oder eine Galaxie, lenkt das Licht ab. Im Gegensatz zur dunklen Materie sind die Sterne der Galaxien sichtbar, aus Farbe und Entfernung konnten die Wissenschaftler deshalb auf deren Masse schließen. Unter der Leitung von Günther Hasinger und seiner Gruppe am Max-Planck-Institut für extraterrestrische Physik wurde das COSMOS-Feld auch mit dem XMM-Newton Teleskop der ESA durchmustert. Dieses Teleskop misst die Röntgenstrahlung von heißem Gas im Universum, also die baryonische Materie, die sich an den Orten zusammenballt, wo besonders viel dunkle Materie vorhanden ist. Das von Alexis Finoguenov am Max-Planck-Institut für extraterrestrische Physik erstellte Röntgenbild hatte für das Kartografieprojekt einen besonderen Wert: Es bestätigte die Verteilung der baryonischen Materie vollkommen unabhängig von den Messungen des Gravitationslinseneffektes und half damit, die verwendete Methode zu eichen.

Quelle: MPG/[CR]

Weitere Infos:

Originalveröffentlichung:

Richard Massey et al. Dark matter maps reveal cosmic scaffolding, Nature (Online-Veröffentlichung, 7. Januar 2007).

http://www.nature.com/.../abs/nature05497.html

http://dx.doi.org/10.1038/nature05497

Homepage des XMM-Newton Projekts:

http://wave.xray.mpe.mpg.de/xmm/

Max-Planck-Gesellschaft zur Förderung der Wissenschaften e.V.:

http://www.mpg.de

Max-Planck-Institut für extraterrestrische Physik, Garching:

http://www.mpe.mpg.de

aus Pro-Physik